対数尤度ベクトルを用いて 1,000 以上の言語モデルを確率分布空間にマッピングし,言語モデルのテキスト生成に関する特性を定量化した本研究は,ACL 2025 で発表され Outstanding Paper Award を受賞しました.

Mapping 1,000+ Language Models via the Log-Likelihood Vector

Momose Oyama (Kyoto University / RIKEN), Hiroaki Yamagiwa (Kyoto University), Yusuke Takase (Kyoto University), Hidetoshi Shimodaira (Kyoto University / RIKEN)

ACL2025のサイト https://2025.aclweb.org/program/awards/

論文のURL https://aclanthology.org/2025.acl-long.1584/

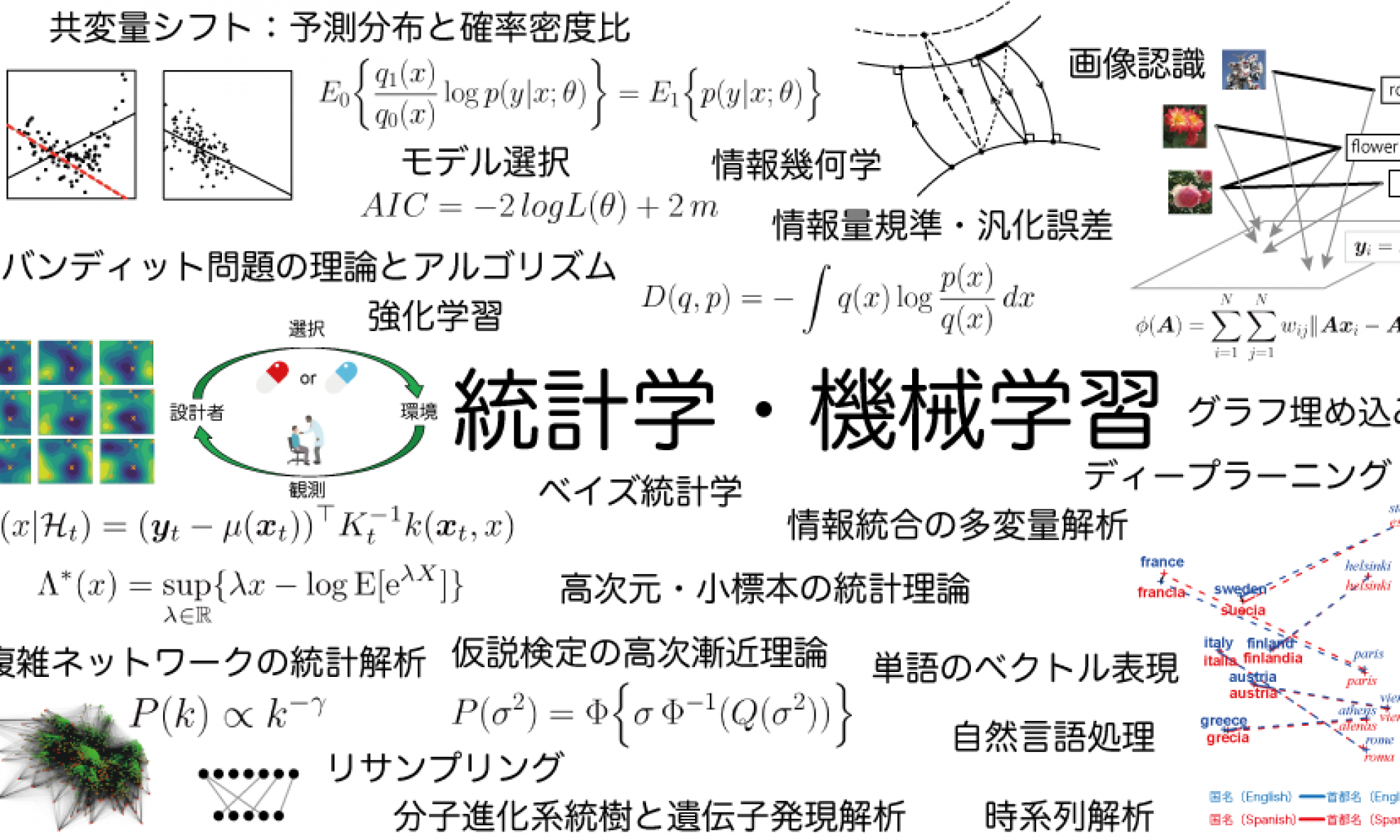

ブログ記事 生成AIモデルの地図:確率分布と情報幾何による類似性の可視化